こんにちは。最近は「ChatGPT」や「Claude」などの対話型AIを日常的に使う人が急増していますよね。質問にすぐ答えてくれる便利さ、文章作成やアイデア出しに役立つ頼もしさ。「これでもう人間の知識なんていらないのでは?」と感じる人すらいるほどです。

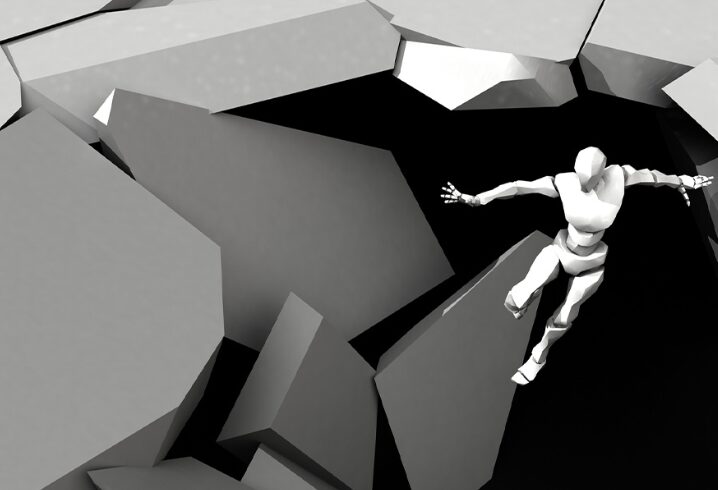

でも実は、この“便利すぎる相棒”にはいくつもの「落とし穴」があります。表面的には頼りになるように見えても、誤った使い方や過信によって、大きなトラブルや損失につながる危険性が潜んでいるのです。

本記事では、対話型AIの落とし穴とリスク、そして賢く使うためのポイントを、解説していきます。

情報の正確性に潜む罠

まず最も大きな落とし穴は、AIが必ずしも「正しい情報」を出してくれるわけではない、ということです。

たとえば、医療や法律のように専門知識が必要な分野では、一見もっともらしい文章でも実は誤情報を含んでいるケースがあります。AIは「断言」してくれるので余計に信じやすい。けれどその裏付けがない場合が多いのです。

- 誤った健康アドバイスを鵜呑みにする

- 出典のない情報でトラブルになる

- 学校のレポートにそのまま貼り付けて減点される

こんな事態になりかねません。つまり「AIが答えを出した=正しい」とは限らないのです。

プライバシーとセキュリティの危険

AIはあなたが入力した情報を学習・処理の材料に使うことがあります。個人情報や社外秘データを不用意に入力すると、それが外部に漏れるリスクがあるのです。

たとえば、会社の内部資料や顧客情報を安易に入力してしまうと、思わぬ形で情報が外部に出てしまうこともあり得ます。

つまり「AIには秘密を打ち明けない」、これが大前提です。

AI依存という精神的な落とし穴

もう一つ意外と深刻なのが「依存」です。

何でもAIに質問しないと安心できない、文章を自分で書けなくなる、思考の習慣そのものをAIに委ねてしまう…そんな人が増えています。

一度便利さに慣れてしまうと、創造力や思考力が衰えていくのです。これは学習やビジネスだけでなく、人生全般に影響を与える落とし穴。

「AIを道具として使う」のか、「AIに操られる人間」になるのか、その境界線は意外に薄いのです。

フェイクの再拡散リスク

AIはインターネット上の膨大な情報を学習しています。そのため、すでに存在している「誤情報」や「古い情報」を再生産してしまうこともあります。

あなたがAIから受け取った情報をSNSなどでそのまま拡散すれば、自分自身が“フェイクニュースの加害者”になってしまう危険があるのです。

便利なはずのAIで、信頼を失う結果になる…これも大きな落とし穴です。

コストと制御不能の問題

さらに見逃せないのがコスト面。無料プランでは制限があるため、有料課金している人も多いでしょう。しかし、いつの間にかサブスクリプション料が積み重なり、コストパフォーマンスを冷静に考えられなくなるケースもあります。

またAIはブラックボックス的存在です。なぜその答えを導いたのかを利用者が理解しきれない部分があり、「制御不能な相棒」としての顔も持っています。

賢く活用するためのポイント

ではどうすれば落とし穴を避け、賢く活用できるのでしょうか?

- 重要情報は必ず人間の専門家で裏取りする

- 個人情報や機密データは絶対に入力しない

- 作業の一部を補助してもらい、最終判断は自分が下す

- 常に複数の情報源と照らし合わせる

- 依存しすぎず「考える習慣」を保つ

ここを徹底するだけで、落とし穴にはまるリスクは大幅に下がります。

結論:AIは万能ではない「協力者」

ここまでお話しした通り、対話型AIは使いこなせば非常に有用ですが、誤情報や依存、セキュリティなど多くの落とし穴を抱えています。

AIは人間を置き換える存在ではなく、共に作業を進める協力者である。この視点を忘れなければ、あなたはAIをただの「危険なおもちゃ」ではなく「強力な相棒」に変えられるはずです。

まとめ

あなたは今、すでにAIをどんな場面で使っているでしょうか? この記事を読みながら「自分も少し依存しているかも」と感じたら、今日から意識してみてください。AIは正しく使えば人生を豊かにする最高のツール。でも、間違えばあなたの足元をすくう落とし穴になる――。

その境目を知ることこそが、これからのAI時代を生き抜く力になるのです。

コメント